4月25日,百度AI开发者大会Create 2025在武汉盛大召开,大会以“模型的世界,应用的天下”为主题,吸引了众多行业内外人士的关注。会上,百度集团执行副总裁、智能云事业群总裁沈抖,分享了百度智能云在智能基础设施建设方面的最新进展,并发布了一系列算力、模型及应用的新产品。

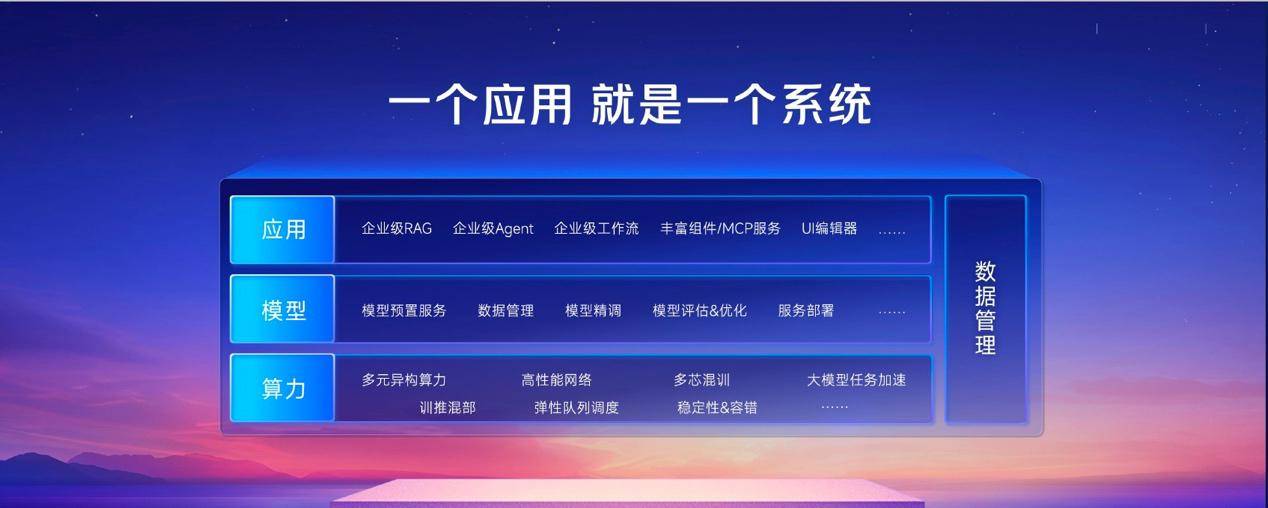

百度强调,为了推动大模型的高效落地,需要从底层算力到应用的全栈、系统级支持。这既包括高性能硬件与集群优化,也涵盖灵活的开发工具链与场景化解决方案。基于在大模型研发与产业落地方面的深厚积累,百度智能云推出了新一代系统级智能基础设施,致力于为企业提供最优的大模型应用落地方案。

沈抖表示,系统的真正价值不仅在于解决具体问题,更在于赋予企业“创造的能力”。企业可以结合自身的数据、流程和逻辑,借助百度智能云的系统级能力,构建专属的AI基础设施。

在算力方面,百度智能云通过自研的昆仑芯P800芯片及百舸大规模推理加速能力,实现了算力性能与成本的双重飞跃。大会上,百度正式点亮了昆仑芯P800的三万卡集群,并宣布该算力已在招商银行、国家电网、同济大学等多家企业和高校进行了规模化部署。

为了进一步降低算力成本,百度智能云推出了昆仑芯超节点,该节点支持将64张昆仑芯AI加速卡置于同一机柜内,从而实现单节点的超强性能。与以往方案相比,昆仑芯超节点通过更快的机内通信替代机间通信,有效降低了带宽成本,提升了卡间互联带宽和单机训练、推理性能。

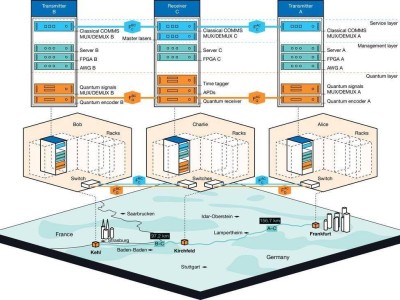

百度智能云还对百舸推理加速能力进行了全面升级,通过大规模分布式推理的PD分离,支持客户根据不同场景的业务特点自适应设置PD配比,并实现了token级别的PD负载均衡。针对MOE模型,百舸进行了极致优化,大幅降低了MOE模型推理的通信开销,并提升了GPU的有效利用率。

在模型服务与应用开发方面,百度智能云的千帆平台提供了超过100个模型,包括文心4.5Turbo、文心X1 Turbo等百度自研模型,以及DeepSeek、Ilama、Vidu等第三方模型。千帆平台还提供全面的模型开发工具链,支持深度思考模型和多模态模型的定制与精调。

本次大会上,千帆平台发布了全新推理式智能体——智能体Pro,该智能体从快问快答升级到深思熟虑,并支持企业定制专属智能体。智能体Pro还支持Deep Research深度研究模式,能够自主完成复杂任务的步骤规划、信息筛选和整理,生成结构清晰、内容丰富的专业报告。

百度智能云还正式发布了国内首个企业级MCP服务,首批已有超过1000个MCP Servers供企业及开发者选择。开发者还可以在千帆平台上开发自己的MCP Server,并发布到MCP广场,享受免费托管服务。

在金融营销领域,百度智能云升级发布了客悦·ONE,针对高精准获客、“高情商”客服及高效的流失预警等核心场景进行全面优化,为客户提供全生命周期智能营销服务。目前,客悦已服务50余家不同细分领域的金融企业,落地了10余个金融场景。

在视觉AI领域,百度智能云升级发布了一见5.0,该产品在标准化高、规则清晰的任务中,仅需一句自然语言即可秒级生成专业级视觉AI应用。借助云边协同,应用成本大幅降低,加速了视觉智能的规模化落地。

目前,百度智能云的系统级能力已在多个企业场景中稳定运行,包括中国钢研与百度智能云联合打造的全栈智能基础设施,以及基于昆仑芯和百舸搭建的专属智算平台等。