近期,科技界迎来了一项新的突破,谷歌DeepMind团队推出了名为QuestBench的新基准,旨在评估大型语言模型(LLMs)在推理任务中识别和获取缺失信息的能力。这一创新工具通过约束满足问题(CSPs)框架,为LLMs在信息不完备场景下的应用提供了更为精确的衡量标准。

在现实世界中,无论是用户提出数学问题时的信息遗漏,还是自主系统在部分可观测环境中工作时的挑战,都凸显了理想化完整信息设定与现实问题之间的矛盾。这一矛盾促使LLMs必须发展出主动信息获取的能力,以应对复杂多变的应用场景。

QuestBench基准的推出,正是为了解决这一难题。它专注于评估LLMs在推理任务中识别缺失信息的能力,将问题形式化为约束满足问题,并特别关注“1-sufficient CSPs”,即那些只需知道一个未知变量值即可解决目标变量的问题。这一框架不仅覆盖了逻辑推理、规划和小学数学等多个领域,还通过变量数量、约束数量、搜索深度和暴力搜索所需猜测次数等四个难度轴,精准揭示了模型的推理策略和性能瓶颈。

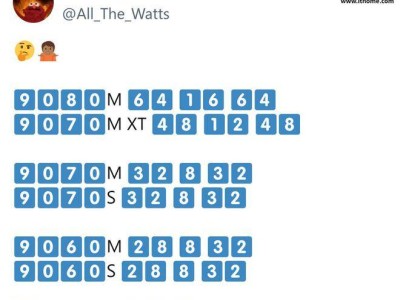

为了全面评估QuestBench基准的有效性,研究者们对包括GPT-4o、Claude 3.5 Sonnet、Gemini 2.0 Flash Thinking Experimental等在内的多个领先模型进行了测试。测试覆盖了零样本、思维链和四样本设置,涉及了288个GSM-Q和151个GSME-Q任务,时间跨度从2024年6月至2025年3月。

测试结果表明,思维链提示在提升模型性能方面发挥了重要作用。在规划任务中,Gemini 2.0 Flash Thinking Experimental模型表现尤为突出。然而,尽管开源模型在逻辑推理方面具有一定的竞争力,但在面对复杂数学问题时,其表现却不尽如人意。研究指出,当前模型在简单代数问题上尚能应对,但随着问题复杂性的增加,其性能显著下降,这凸显了在信息缺口识别和澄清能力上的巨大改进空间。

QuestBench基准还揭示了不同模型在不同难度轴上的表现差异。例如,在某些变量数量较多、约束条件复杂的问题上,某些模型可能表现出更高的搜索深度和更强的猜测能力,而在其他情况下,则可能因缺乏足够的信息而陷入困境。这些发现为未来的模型优化和算法改进提供了宝贵的参考。

QuestBench基准的推出不仅为LLMs在信息不完备场景下的应用提供了新的衡量标准,也为未来的模型优化和算法改进指明了方向。随着技术的不断进步和应用的日益广泛,我们有理由相信,LLMs将在更多领域展现出其强大的推理能力和应用价值。