在AI领域的一次深夜震撼发布中,阿里巴巴以其迭代速度惊人的千问系列再次吸引了全球目光。这一次,他们推出的Qwen3系列大模型,如同一颗重磅炸弹,直接挑战了包括DeepSeek在内的顶尖模型,并对Gemini 2.5 Pro构成了强烈冲击。更引人注目的是,Qwen3不仅是全球首个开源的混合推理模型,还支持多达119种语言和方言,同时兼容MCP协议,一举夺得了全球开源模型排行榜的桂冠。

这一消息迅速在开发者社区中引爆了热潮,讨论热度直线飙升。

Qwen3系列此番带来的“豪华套餐”内容丰富多样。告别了过去单一参数的大模型时代,Qwen3采取了“组合拳”策略,推出了两大类型的模型。

首先是MoE(混合专家)模型,包括旗舰级的Qwen3-235B-A22B,总参数超过2350亿,但实际激活参数仅为220亿多,性能卓越;另一款则是“小钢炮”Qwen3-30B-A3B,拥有300亿总参数和30亿激活参数,效率惊人。MoE模型的工作原理类似于聘请了一群专家,只在需要时调用最相关的几位,从而大大节省了时间和资源。

接着是Dense(密集)模型,共六款,从Qwen3-32B到Qwen3-0.6B,覆盖了不同规模的算力需求,真正做到了灵活选择,且每款模型都展现出了极高的“能效比”。

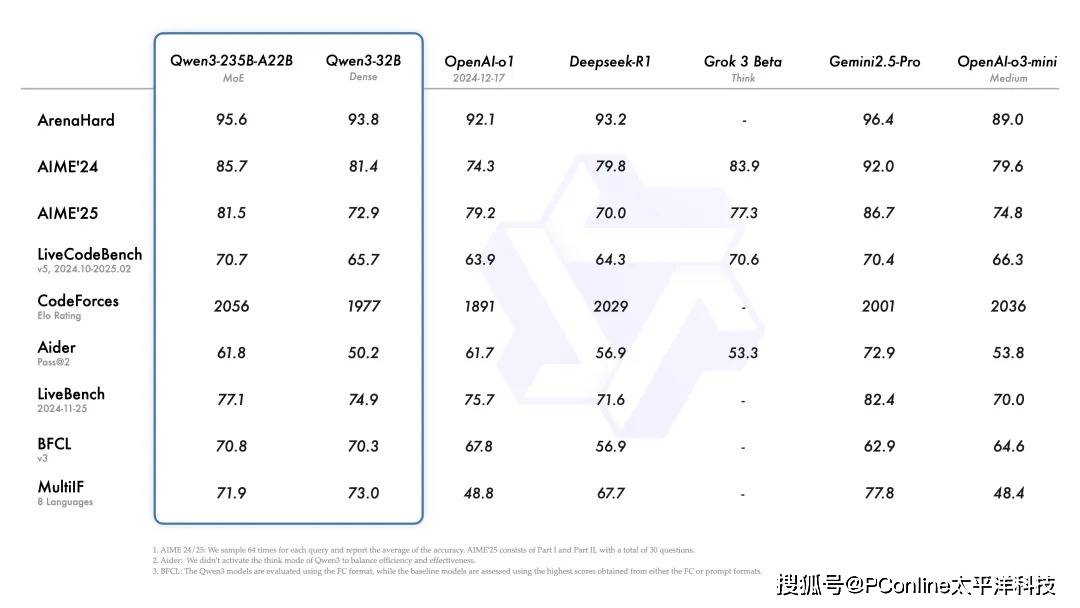

在性能表现上,Qwen3主打“能效比”。旗舰模型Qwen3-235B-A22B在代码、数学、通用能力等基准测试中均取得了极具竞争力的成绩。

尤为值得一提的是效率的提升,如30B的MoE模型Qwen3-30B-A3B,仅用相当于32B Dense模型10%的激活参数,就实现了更优的性能。即便是小模型Qwen3-4B,也能与上一代Qwen2.5-72B-Instruct相媲美,实现了资源的最优化利用。Qwen3的Dense模型在同等尺寸下,整体性能也超越了参数量更大的Qwen2.5同类模型,特别是在数理、代码、推理方面表现更为突出。

Qwen3的核心亮点不仅在于参数的提升,更在于其创新的双重思考模式。面对复杂问题时,模型会进行深入推理,如同老教授般严谨;而面对简单问题时,则会迅速响应,追求效率。用户还可以根据需求动态控制和切换思考模式,实现了对模型“思考预算”的精细化管理。

Qwen3还具备全球化视野,支持119种语言和方言,真正实现了沟通无界限。其Agent能力也得到显著增强,支持MCP协议,在工具调用和代码执行等方面进行了优化,使其更加擅长作为智能助理,与环境交互解决问题。

最重要的是,Qwen3系列强大的模型,包括预训练基础模型和后训练的对话模型,现已全部开源。用户可以通过Hugging Face、魔搭社区(ModelScope)、Kaggle等主流平台免费下载并进行商业使用。开发者还可以通过阿里云百炼平台调用API,并推荐使用SGLang、vLLM等框架进行部署。对于希望在本地体验的用户,Ollama、LMStudio、MLX、llama.cpp、KTransformers等工具也已提供支持。

普通用户则可以通过通义官网或app直接体验Qwen3,夸克也即将接入,让更多人能够轻松享受到AI带来的便利。

尽管每次新模型的发布都少不了实测环节,但从普通用户的角度来看,如今的大模型在功能上已相差无几。各家的差异主要体现在背后的资源调用和成本效益上。因此,我们也仅通过几个简单测试来感受Qwen3的实力。

例如,在数字母测试中,大部分我们能免费使用的模型都未能通过。同样,Qwen3虽然能够识别出梗图中的大部分关键信息,但也遗漏了最关键的一点:东云名乃对自己机器人身份的纠结。

回顾Qwen系列的成长历程,从2023年的Qwen1.0初出茅庐,到2024年Qwen2.0的锋芒毕露,再到如今的Qwen3.0的成熟稳健,每一步都充满了挑战与不易。在全球AI领域的激烈竞争中,阿里巴巴不仅投入了大量资金,更汇聚了顶尖的技术积累,并坚持开源战略,赢得了开发者的广泛尊重。

Qwen系列的发展,是中国AI力量崛起的一个生动写照。它告诉我们,只要有持续的投入、正确的方向和足够的韧性,就能在最前沿、竞争最激烈的科技领域不断取得突破,创造更多惊喜。