RWKV基金会近期在人工智能领域迈出了重要一步,正式公布了其最新研发成果——RWKV7-G11.5B推理模型。这款模型以其卓越的推理能力和对多语言的广泛支持,尤其适合在诸如手机等端侧设备上运行,为用户带来更加流畅和智能的体验。

RWKV7-G11.5B模型是基于庞大的World v3.5数据集进行训练的,该数据集涵盖了小说、网页、数学、代码以及专门的推理数据,总数据量高达5.16万亿个词汇单元。这样的训练基础,使得模型在逻辑推理方面展现出了非凡的实力,能够轻松应对多语言、数学以及代码相关的各种任务。

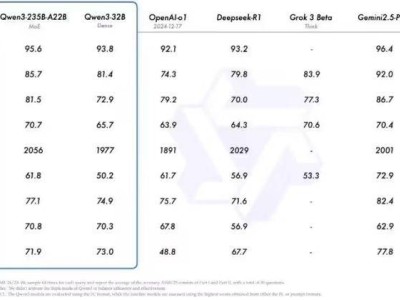

在MMLU(多语种数学语言理解)评测中,RWKV7-G11.5B模型的表现尤为亮眼,其准确度高达48.2%,相较于之前的RWKV-7World1.5B模型,有了显著的提升。在与同规模开源模型的对比中,RWKV7-G11.5B在英语和多语言能力方面也展现出了明显的优势,甚至超过了同期发布的Qwen3-1.7B-Base模型。

在另一项名为“无法作弊的评测”中,RWKV7-G11.5B模型同样表现出色。这项评测使用实时数据,如最新的论文和新闻文章,来评估开源大语言模型的真实建模能力和泛化能力。在同参数规模的开源模型中,RWKV7-G11.5B的综合得分名列前茅,仅次于参数更多的Qwen3-1.7B模型,超越了Qwen2.5-1.5B等其他模型。

RWKV7-G11.5B模型不仅支持全球超过100种自然语言,而且在多语言翻译任务中表现出色,能够准确地将中文翻译为多种语言。该模型还具备一定的代码能力,能够解答Leetcode上的编程题目,并在数学题目解答中展现出了高水平的准确性。

为了让更多用户能够体验到RWKV7-G11.5B模型的强大功能,RWKV基金会提供了多种便捷的体验方式。用户可以通过Hugging Face或魔搭社区的在线demo来试用已完成训练的RWKV7-G10.1B、0.4B和1.5B模型。同时,RWKV基金会还推出了处于内测阶段的RWKV端侧聊天APP,该应用支持Android和iOS系统,让用户能够随时随地与模型进行互动。

RWKV基金会的发布计划十分周密,目前已经发布了G10.1B、0.4B和1.5B三个版本的模型,而更大规模的G12.9B模型也预计将在不久后与公众见面。基金会还在积极准备更大更优的数据集World v3.7,以期训练出性能更加强劲的RWKV7-G17B模型。

对于想要快速体验RWKV7-G11.5B模型的用户,可以通过以下链接访问Hugging Face平台上的在线demo:https://huggingface.co/spaces/RWKV-Red-Team/RWKV-LatestSpace