近日,阿里巴巴云旗下的Qwen团队推出的Qwen3-235B-A22B大型语言模型,在HuggingChat平台上隆重亮相,迅速吸引了业界的广泛关注。这一开源模型凭借其卓越的推理能力、创新的模式切换机制以及高效的性能,成为开源AI领域的新星。

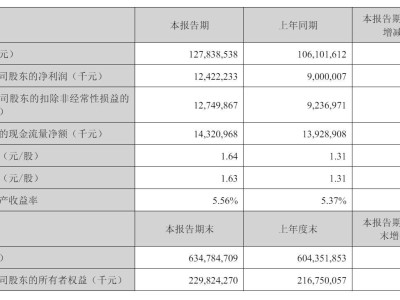

Qwen3-235B-A22B作为Qwen团队最新的混合专家(MoE)模型,拥有高达2350亿的总参数,其中220亿为激活参数。通过MoE架构的优化,该模型在提升性能的同时,也显著提高了推理速度和资源利用效率。尤为Qwen3-235B-A22B支持长达32768个令牌的原生上下文长度,并可通过YaRN技术扩展至131072个令牌,使其在处理复杂长文本任务时游刃有余。

该模型还引入了独特的“混合思维”设计理念,实现了思考模式与非思考模式之间的无缝切换。思考模式专注于数学、编码和复杂逻辑推理等深度思考任务,而非思考模式则专为日常对话提供快速响应。这种灵活的模式切换机制,让用户能够根据不同任务需求精准调配计算资源,实现了性能与效率的完美平衡。

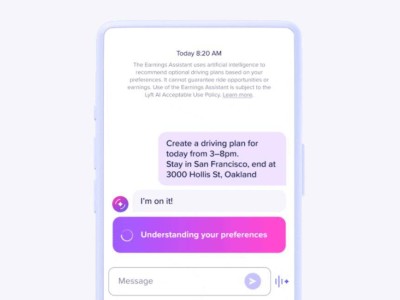

HuggingChat平台作为Hugging Face旗下的开源AI对话平台,一直以来以其开放性和易用性受到开发者们的青睐。Qwen3-235B-A22B在HuggingChat的上线,标志着这一前沿技术正式向全球用户敞开怀抱。用户们纷纷表示,该模型的响应速度惊人,对话自然流畅,为他们带来了前所未有的交互体验。

Qwen3-235B-A22B在HuggingChat平台的部署,极大地降低了使用门槛。无论是专业研究人员、开发者,还是普通用户,都可以通过平台轻松体验这一顶级模型的强大功能,无需繁琐的本地配置。这一开放性举措不仅加速了技术的普及,也为开源AI社区注入了新的活力与动力。

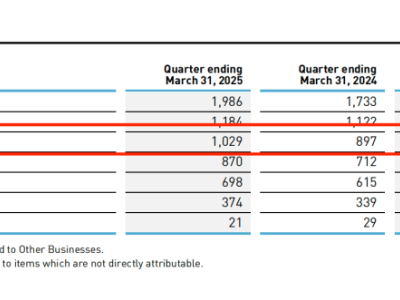

在多个基准测试中,Qwen3-235B-A22B展现出了与业界顶级模型相抗衡的实力。无论是在编程竞赛平台Codeforces、数学基准AIME,还是在逻辑推理测试BFCL上,该模型都取得了优异成绩,部分成绩甚至超越了OpenAI的o3-mini和谷歌的Gemini2.5Pro。在代码生成、创意写作和多轮对话等场景中,Qwen3-235B-A22B同样表现出色,尤其在人类偏好对齐方面更具优势,为用户带来了更加自然和沉浸的交互体验。

Qwen3系列还支持多达119种语言和方言,显著提升了多语言处理能力。这一特性为全球用户提供了更广泛的应用可能性,也为非英语地区的研究和应用提供了重要支持。Qwen3-235B-A22B的开源发布,不仅推动了多语言AI技术的发展,也为整个开源AI领域注入了新的创新活力。

感兴趣的用户可以通过HuggingFace的官方链接(https://huggingface.co/chat/models/Qwen/Qwen3-235B-A22B)体验这一顶级模型。